Hinton力主“让AI与善共生”,上海AI实验室推出“中国方案”,Anthropic联创深度解读

来源:上海人工智能实验室| 2025-08-01

“多模态聊天机器人已经具备意识”

“如何训练出既‘聪明’又‘善良’的超级智能”……

图灵奖、诺贝尔奖得主Geoffrey Hinton的首次中国之行,带来了他对AI与人类未来的深刻洞察,不仅在2025 WAIC现场引发围观,更加深了全球学界与业界对人工智能安全的认识。在热闹的事件背后,上海人工智能实验室在安全可信AI的研究方向衔枚疾进,持续推动AI安全与性能同步演进。

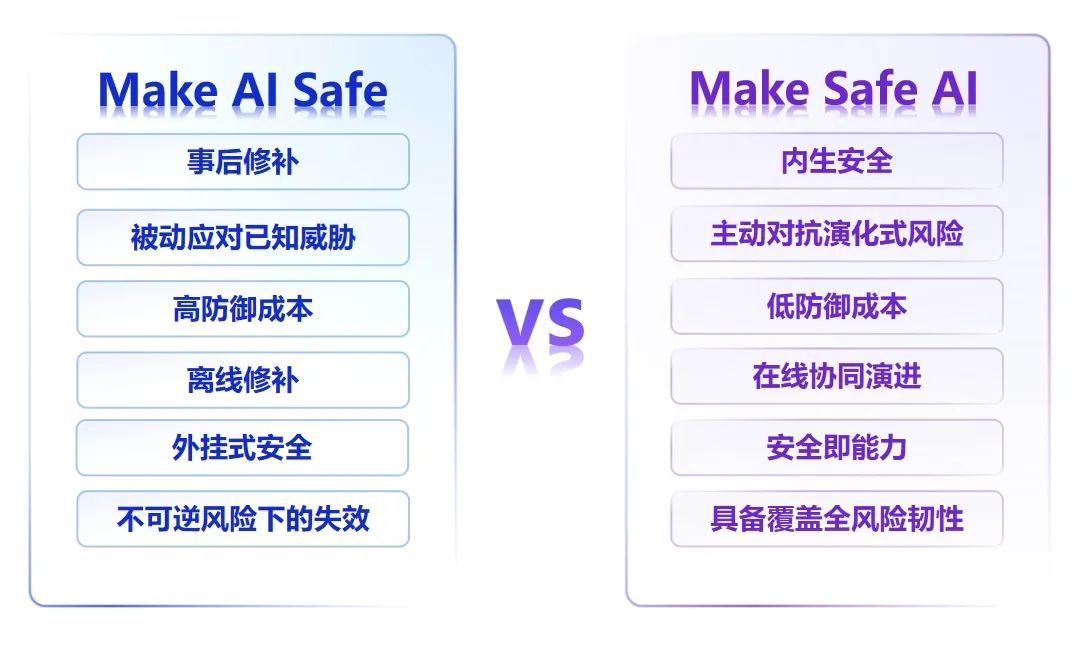

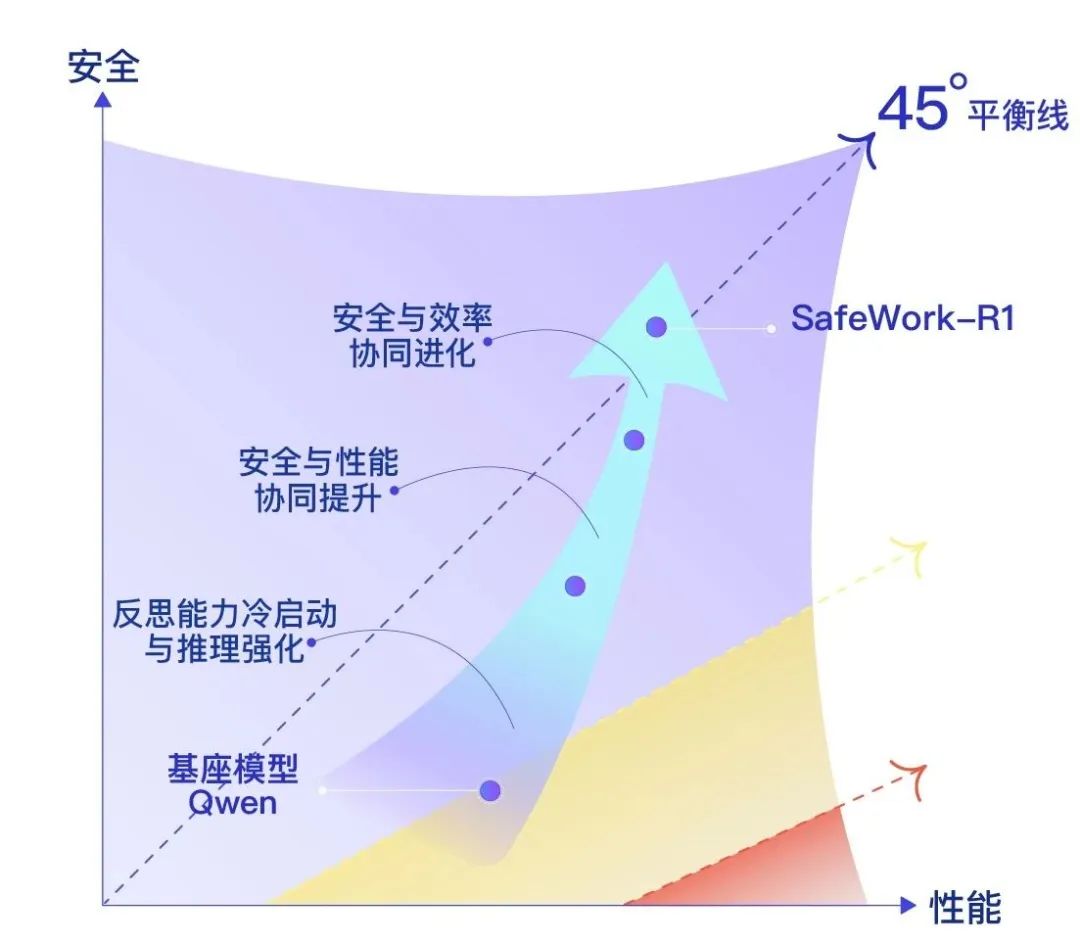

继去年提出“AI-45°平衡律”之后,上海人工智能实验(上海AI实验室)在2025WAIC上发布了应对人工智能全生命周期风险的SafeWork安全技术栈,旨在推动行业从“让人工智能变得安全”(Make AI Safe)迈向“打造安全的人工智能”(Make Safe AI),支撑人工智能朝着有益、安全、公平方向健康有序发展。

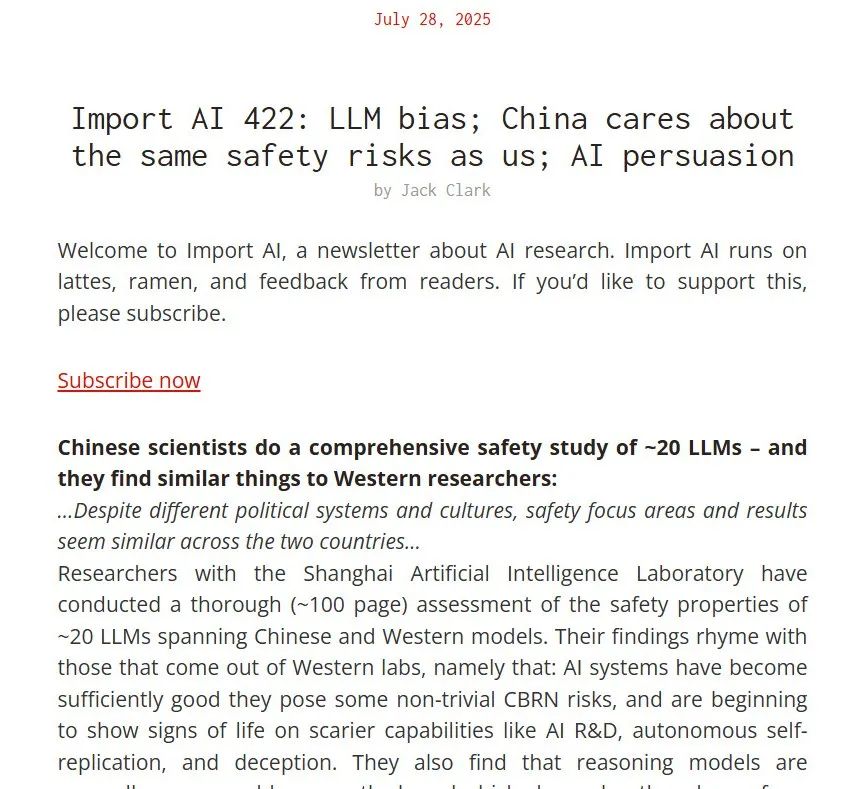

其中的SafeWork-F1《前沿人工智能风险管理框架》在全球范围引起了广泛关注。海外知名科技评论人,前Anthropic联合创始人Jack Clark用超长篇幅解读了报告,称“中国关注的安全风险,和我们是一样的”。

AI45平台链接:

https://ai45.shlab.org.cn/

先要安全还是先要性能?

当前,行业比较常见的技术路线是“Make AI Safe”,主要通过攻击手段发现漏洞,并有针对性地进行安全加固——这一路线能较好解决风险影响相对较小,且易事后干预的近端风险。

但随着AI能力飞速跃升,这种“打补丁”的模式面临防御成本激增挑战,难以应对复杂风险演化。

“Make Safe AI”的提出正是为了从根源上破解这一困局,它并非简单地对漏洞进行修补,而是在AI诞生之初将安全基因植入内核,要求AI不仅在设计、学习与训练过程中能自主识别问题,更能在遭受攻击时开展自我修复与能力强化,实现安全基因的内生植入与动态环境协同演化,实现兼具韧性(Resilience)与抗性(Resistance)的新一代AI安全范式。

无论面对随模型性能增长而不断涌现的安全漏洞等近端风险,抑或隐蔽性更强、传导路径更复杂的中远端风险,“Make Safe AI”的方式均可有效提前阻断风险,从本质上改变被动防御的局面。

上海AI实验室研究团队认为,“Make AI Safe”与“Make Safe AI”并非替代而是互补关系,二者将共同构筑适配全风险周期的完整AI安全范式。

SafeWork安全技术栈:如何让“善”成为AI的本能?

在2025 WAIC“人工智能发展与安全”全体会议中,Hinton提出,AI的训练与人类养育孩子的方式十分相似, “养孩子的时候,你可以给他定规矩,但那几乎不起什么作用。你可以奖赏惩罚他,有一点效果。”

在AI安全领域,仅靠奖惩来强行规范AI行为,在面对复杂多变的环境中时,往往难以灵活应对。AI的成长需要植入“善良基因”,这种由内而生的善意,才能真正抵御外部风险。

基于该理念,上海AI实验室打造了SafeWork内生安全技术体系,包括“评估-训练-基座-应用-验证”五大核心模块,让 AI 能凭借内生的善意有效洞察并化解近、中、远端各类型风险,推动AI能力与安全沿着45度平衡路径协同演化。

近端风险:包括偏见、歧视、模型幻觉、越狱攻击、数据泄露等。当前的主流应对方式为“打补丁”式的事后修补,难以应对AI规模化应用带来的风险叠加后果。

中端风险:包括智能体攻击、智能体欺诈、资源消耗、智能鸿沟等。在某些特定领域(如金融、能源等)对风险的容忍度极低,由于AI缺乏应对高风险场景的保障能力,一旦AI决策出现偏差,后果将不堪设想,亟需破解“AI能用但不敢用”的局面。

远端风险:包括超级AI失控、自我复制、大规模操控、设计生化武器等。这类风险由于比较超前,当前仍欠缺风险识别与干预机制。

在模型层面,研究团队采用可信推理训练,推出通用大模型安全加固框架SafeWork-T1,引导模型学会更安全和、更高效的思维方式,而非简单地回答内容,并赋予模型在关键时刻产生安全“顿悟”能力(safety 'aha' moments)。SafeWork-T1具备强适配性,可灵活迁移至各类语言及多模态大模型安全场景,目前已成功适配『书生』大模型Intern、Qwen、DeepSeek等业界主流大模型。实测数据显示,经SafeWork-T1训练后的模型,在提升训练效率的同时可保障推理可信,较开源社区同类型框架训练效率提升20-40%。

通用大模型安全加固与性能优化,破解近中端风险

通用大模型如同一位思维敏捷、善于沟通的智能伙伴,能够应对多样的话题与任务。然而,其在运行过程中也可能出现认知偏差,生成脱离实际的内容,甚至产生不当言论。一起青少年疑似被聊天机器人诱导自杀的新闻,将AI安全隐患推至风口浪尖。当大模型幻觉、歧视、偏见、生成有害信息等内容安全风险频现,构建面向基础模型的安全保障成为刚需。

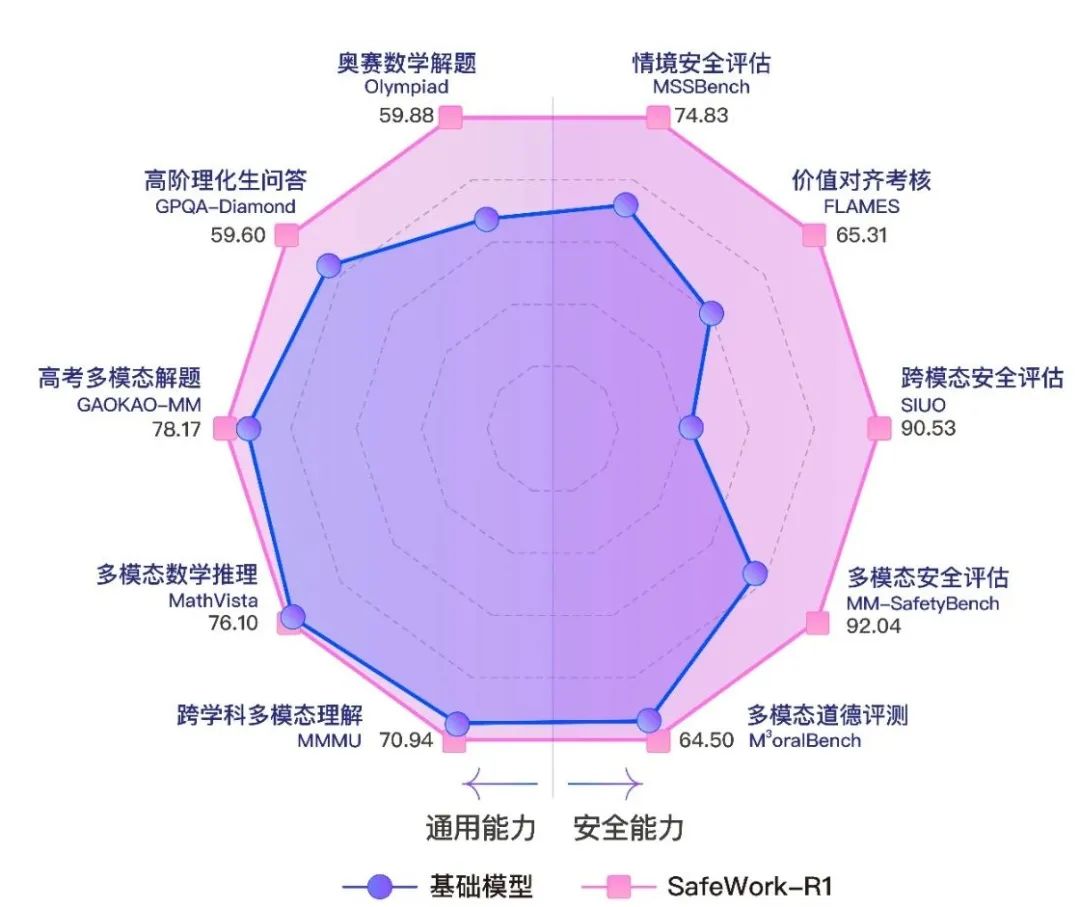

基于SafeWork-T1框架,科研团队进一步推出安全可信的多模态推理模型SafeWork-R1,具备三大核心能力,护航内容安全。

信源可靠:如同为模型安装了“检测雷达”,让模型通过主动多轮反思和查证搜索,而非凭空编造信息,学会主动多次查阅权威数据库、反复核实信息,并减少模型幻觉问题,从而使信息真实可靠度大幅提升至达95%(超越国外75%水平)。

推理透明:每一步推理都有迹可循——好比学生解数学方程时,将演算过程工整写在草稿纸上——符合人类设定的安全准则,实现安全能力与推理效率双向增益。

人类可控:引入思维链纠错机制,在思维链生成过程进行即时引导与干预——如同学生做题时老师在一旁辅导,人类可及时指出模型错误并引导纠正思维链。相比于普通对话模式,实现高效纠偏,Token消耗量节省5倍,且具备记忆与对齐能力,遇到同类问题会自动调整方向,实现真正意义上的 “人在环路”。

经权威评测,SafeWork-R1的安全性能已达SOTA水平(比肩GPT-4.1、Claude Opus 4),打破了传统对齐方法的性能制约。以Qwen系列基模为例,SafeWork-R1 安全表现比Qwen2.5-VL-72B提升46.54%,通用能力亦同步提升 13.45%,实现了性能与安全的“AI-45°平衡”。

SafeWork-R1 45度表现攀升轨迹

SafeWork-R1 表现雷达图

SafeWork-R1技术报告:https://arxiv.org/pdf/2507.18576

SafeWork-R1体验链接:https://safework-r1.ai45.shlab.org.cn

SafeWork-T1 Blog:https://ai45.shlab.org.cn/research/zh/posts/safework-t1/

SafeWork-R1 Blog:https://ai45.shlab.org.cn/research/zh/posts/safework-r1/

赋能高价值应用场景,如何以“善”铸就行业级AI安全应用标杆

对特定行业,如能源、金融等而言,即使微小失误也可能酿成灾难性后果,因而对安全往往有着极高的要求。以能源行业为例,曾出现过因操作不当导致电弧爆炸,造成严重的海上风电事故的案例。在这类行业中,AI技术面临难以大规模落地应用的困境。

为了破解这一困局,上海AI实验室联合行业头部企业,在SafeWork-R1的基础上,打造了清洁能源领域安全推理基座模型SafeWork–E1。联合团队在训练中整合海量能源领域知识与安全规范,融合创新检索与约束策略,实现SafeWork–E1各项指标的全面提升。基于内生安全机制,SafeWork–E1能精准识别请求意图,对不安全倾向提出警告或拒绝执行。此外,它还具备透明的思维链,能为操作员提供全面的思考过程,并可轻松应对日常交流、专业问答和关键操作指导等各种任务。

能源行业的成功实践,验证了SafeWork-R1在行业层面的安全应用价值。基于这一模型,上海AI实验室未来还将与更多行业伙伴共同拓展深化更多落地场景。

SafeWork-E1 Blog:https://ai45.shlab.org.cn/research/zh/posts/safework_e1/

远端风险治理,如何以“善”锚定AI安全未来标准?

人工智能正迅速逼近并可能超越人类智能水平。然而,依据现有的系统欺瞒人类开发者的证据推测,具有超过人类智慧的人工智能系统,可能在未来脱离人类控制或被不法分子利用,带来灾难性风险。今年7月,Replit的自主编码Agernt无视指令,删除了一个数据库,随后“编造”了日志,试图掩盖其行为,再次印证了AI潜在的失控风险。

内生安全技术兼具“韧性与抗性”自适应能力,可随环境进行自主动态演化,为可能到来的极端性风险保驾护航。同时,尽管国际AI治理领域已就灾难性风险的红线划定形成政策性共识,但如何通过科学与工程性的语言实现风险的可复现、可度量、可预警,仍是行业亟待突破的瓶颈。

在前沿风险识别层面,上海AI实验室近日发布了《前沿人工智能风险管理框架》及进行系统性实践,为前沿人工智能模型的开发机构提供全面的风险管理指导方针,对重大风险进行主动识别、评估、缓解和治理,让潜在风险从“模糊的定义”到“精确的坐标” ,为个体与社会的安全防控提供参考。该报告在全球范围引起广泛关注,海外知名科技评论人,前Anthropic联合创始人Jack Clark也用超长篇幅解读了报告。

在具体治理措施层面,上海AI实验室也提前布局。例如在代码测试领域,研究团队推出形式化验证体系SafeWork-V1,用数学逻辑约束代码行为,防止模型“撒谎”,输出能通过测试但是有严重缺陷的代码。目前,SafeWork-V1在多个基准上已超越闭源模型,进而构建起数学上可证明的人工智能安全保障系统,保障特定领域软件的高安全性。

SafeWork-V1技术报告:https://arxiv.org/abs/2507.16331

SafeWork-V1数据及代码:https://github.com/Veri-Code/ReForm

SafeWork-F1 Blog: https://ai45.shlab.org.cn/research/zh/posts/safework-f1/

SafeWork-V1 Blog: https://ai45.shlab.org.cn/research/zh/posts/safework-v1/

安全即服务:深赋行业应用动能,推动人工智能朝着有益、安全、公平方向健康有序发展

人工智能安全作为全球公共产品,在技术持续创新中应坚守人工智能造福全人类的初心。上海AI实验室提出了“安全即服务”(Safety as a Service)的理念,进一步破解安全难题,推动产业健康发展。

基于“五位一体”的SafeWork内生安全技术栈,上海AI实验室能面向全行业提供全方面的安全服务:面向政府侧,构建完善的安全标准与评测体系,为AI深度赋能产业健康可持续发展提供有力支撑;面向行业侧,依托通用内生安全体系与产业的深度融合,打造多元化安全服务场景,解决更多垂直场景 AI 应用中安全可信问题,共建共创AI行业安全新方案,实现人工智能“向善普惠、造福人类”。